Wie Computer lernen, den Sinn von Texten zu erfassen

Bisher stoßen Computer aber noch an ihre Grenzen, wenn sie die Bedeutung von Wörtern in einem Textzusammenhang erfassen sollen oder wenn man Querbezüge zwischen einzelnen Sachverhalten in großen Textmengen herstellen möchte. Auf einer Tagung in Saarbrücken diskutieren Computerlinguisten daher, wie man die maschinelle Sprachverarbeitung verbessern kann. Rund hundert Wissenschaftler aus verschiedenen europäischen Ländern, Japan und den USA werden bei der Konferenz zur Verarbeitung Natürlicher Sprache (Konvens) erwartet, die vom 6. bis 8. September auf dem Universitätscampus stattfindet.

Seitdem man durch das Internet und leistungsfähigere Rechner schnell auf riesige Mengen von Textdaten zugreifen kann, versuchen Forscher, noch mehr Intelligenz in die Suche einzubauen. Eine zentrale Herausforderung ist dabei die Flexibilität der Sprache: Ein Sachverhalt kann auf sehr unterschiedliche Weise ausgedrückt werden. Ein Wort oder auch ein Satz kann viele verschiedene Informationen ausdrücken und bekommt seinen genauen Sinn erst im Kontext. „Die Wissenschaftler gingen anfangs davon aus, dass man die Computer mit sehr viel Wissen füttern muss, um sie dann in die Lage zu versetzen, Sachverhalte aus Texten zu erschließen und logische Verbindungen zwischen verschiedenen Sachverhalten zu knüpfen“, erläutert Manfred Pinkal, Professor für Computerlinguistik der Universität des Saarlandes und Organisator der diesjährigen Konferenz. „Wenn man zum Beispiel im Internet herausfinden will, ob Firma A von Firma B übernommen wurde, und ein Textdokument findet, in dem von der Veräußerung von Firma B an Firma A durch eine dritte Firma die Rede ist, dann muss der Computer dafür die Sprache genau analysieren. Er muss richtig interpretieren, wer im jeweiligen Kontext Verkäufer, Käufer oder Kaufinteressent ist“, erklärt Pinkal. Der Mensch könne solche Texte mit seinem Hintergrundwissen schnell und problemlos deuten, der Computer jedoch nicht.

Vor einigen Jahren mussten sich die Forscher eingestehen, dass die Zusammenhänge zu komplex sind und man riesige Wissensmengen benötigt. Es wurde deutlich, dass das Verstehen von Texten auf der Grundlage von Wissen praktisch unmöglich ist. Seit einigen Jahren versuchen Forscher daher, über andere Wege zum gleichen Ziel zu kommen, nämlich Sprache in ihrer Komplexität automatisch zu erfassen. „Mit Hilfe von statistischen Lernverfahren gelingt es Computerlinguisten heute immer besser, die Bedeutung einer großen Textmenge sinnvoll zu erfassen. Der Rechner vergleicht dabei verschiedene Muster, setzt einzelne Wörter in Zusammenhang und lernt eigenständig dazu, wenn Informationen auf ähnliche Weise immer wiederkehren“, erläutert der Saarbrücker Forscher.

Dieses Thema wird der renommierte Computerlinguistiker Ed Hovy vom Information Sciences Institute (ISI) in Marina del Rey (Kalifornien) auf der Saarbrücker Tagung vorstellen. Die Wissenschaftler wollen dann darüber diskutieren, wie die unterschiedlichen Forschungsansätze miteinander verknüpft werden können. Die Konferenz befasst sich auch mit weiteren Themen, zum Beispiel, wie man Dialekte oder kleinere Sprachen wie das Schweizerdeutsch besser maschinell verarbeiten kann. „Viele Sprachdialogsysteme funktionieren heute nur mit weit verbreiteten Sprachen, weil man dort über die erforderliche Software und große aufbereitete Textmengen verfügt, mit denen man die Computer trainieren kann“, sagt Manfred Pinkal. Für die selteneren Sprachen, aber auch für historische Texte sei es daher wichtig, neue Analysewerkzeuge zu entwickeln. Damit hätten in Zukunft auch Kulturwissenschaftler vielfältige Möglichkeiten, um mit Hilfe des Computers große und heterogene Datenbestände zu analysieren und sinnvoll zu interpretieren.

Die Konferenz zur Verarbeitung Natürlicher Sprache wird alle zwei Jahre von drei wissenschaftlichen Fachgesellschaften, nämlich der Deutschen Gesellschaft für Sprachwissenschaft (Sektion Computerlinguistik), der Gesellschaft für Sprachtechnologie und Computerlinguistik und der Österreichischen Gesellschaft für Artificial Intelligence organisiert.

Tagungsprogramm und weitere Informationen unter:

www.konvens.de

Fragen beantwortet:

Prof. Dr. Manfred Pinkal

Tel. 0681/302-4344

Mail: pinkal@coli.uni-saarland.de

Hinweis für Hörfunk-Journalisten: Sie können Telefoninterviews in Studioqualität mit Wissenschaftlern der Universität des Saarlandes führen, über Rundfunk-ISDN-Codec. Interviewwünsche bitte an die Pressestelle (0681/302-3610) richten.

Media Contact

Alle Nachrichten aus der Kategorie: Informationstechnologie

Neuerungen und Entwicklungen auf den Gebieten der Informations- und Datenverarbeitung sowie der dafür benötigten Hardware finden Sie hier zusammengefasst.

Unter anderem erhalten Sie Informationen aus den Teilbereichen: IT-Dienstleistungen, IT-Architektur, IT-Management und Telekommunikation.

Neueste Beiträge

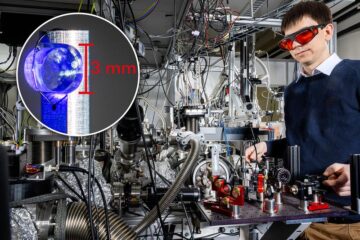

Atomkern mit Laserlicht angeregt

Dieser lange erhoffte Durchbruch ermöglicht neuartige Atomuhren und öffnet die Tür zur Beantwortung fundamentaler Fragen der Physik. Forschenden ist ein herausragender Quantensprung gelungen – sprichwörtlich und ganz real: Nach jahrzehntelanger…

Wie das Immunsystem von harmlosen Partikeln lernt

Unsere Lunge ist täglich den unterschiedlichsten Partikeln ausgesetzt – ungefährlichen genauso wie krankmachenden. Mit jedem Erreger passt das Immunsystem seine Antwort an. Selbst harmlose Partikel tragen dazu bei, die Immunantwort…

Forschende nutzen ChatGPT für Choreographien mit Flugrobotern

Robotik und ChatGPT miteinander verbinden… Prof. Angela Schoellig von der Technischen Universität München (TUM) hat gezeigt, dass Large Language Models in der Robotik sicher eingesetzt werden können. ChatGPT entwickelt Choreographien…