Neuartige Software kann Blickkontakt in alltäglichen Situationen erkennen

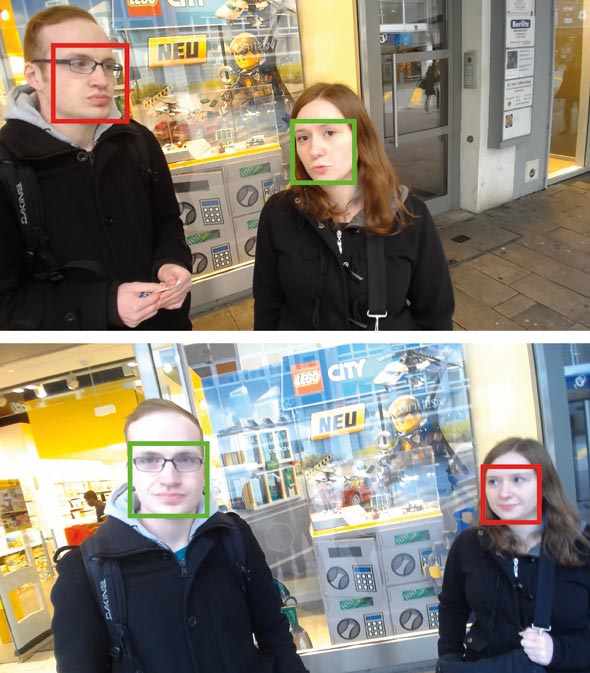

Die neuartige Software erkennt mit Hilfe von lediglich einer Kamera, ob eine oder gar mehrere Personen ein Zielobjekt anschauen (grüner Kasten) oder nicht (roter Kasten). Fotos: Universität des Saarlandes

„Wenn Sie ein Werbeplakat in der Fußgängerzone aufhängen oder Werbung und wissen wollen, wie viele Personen es tatsächlich anschauen, hatten Sie bisher keine Chance“, erklärt Andreas Bulling, der am Exzellenzcluster der Universität des Saarlandes und am Max-Planck-Institut für Informatik die unabhängige Nachwuchsgruppe „Perceptual User Interfaces“ leitet.

Denn bisher sucht man diese wichtige, aber auch simple Information zu erfassen, indem man die Blickrichtung maß. Das setzte spezielle Kameras, deren minutenlange Kalibrierung voraus, und vor allem galt: Jeder musste eine solche Kamera tragen. Tests wie in der Fußgängerzone oder gar nur mehreren Personen waren damit im besten Fall sehr aufwendig, im schlimmsten Fall unmöglich.

Selbst wenn die Kamera am Zielobjekt, beispielsweise am Poster, saß und Maschinelles Lernen eingesetzt wurde, der Computer also mithilfe einer ausreichenden Menge von Beispieldaten trainiert wurde, konnten nur Blicke auf die Kamera selbst erkannt werden.

Zu oft war der Unterschied zwischen den Trainingsdaten und den Daten in der Zielumgebung zu groß. Ein universeller Blickkontakt-Erkenner, einsetzbar sowohl für kleine und große Zielobjekte, in stationären und mobilen Situationen, einen Anwender oder gar eine ganze Gruppe oder unter wechselnden Beleuchtungssituationen, war bislang nahezu unmöglich.

Zusammen mit seinem Doktorand Xucong Zhang und seinem Postdoktorand Yusuke Sugano, der nun Professor an der Universität Osaka ist, hat Bulling nun eine Methode entwickelt [1], die auf einer neuen Generation von Algorithmen zur Blickrichtungsschätzung basiert. Diese verwenden eine spezielle Art von neuronalem Netzwerk, das unter dem Begriff „Deep Learning“ aktuell in vielen Bereichen der Industrie und Wirtschaft für Furore sorgt.

Bereits seit zwei Jahren [2] arbeiten Bulling und seine Kollegen damit und haben es Schritt für Schritt weiterentwickelt [3]. Im nun vorgestellten Verfahren wird zunächst ein sogenanntes Clustering (Ballungsanalyse) der geschätzten Blickrichtungen durchgeführt. Mit der gleichen Strategie kann man beispielsweise auch Äpfel und Birnen anhand verschiedener Merkmale sortieren, ohne explizit vorgeben zu müssen, worin sich die beiden unterscheiden.

In einem zweiten Schritt wird dann der wahrscheinlichste Cluster identifiziert und die darin enthaltenen Blickrichtungsschätzungen für das Training eines, für das Zielobjekt spezifischen, Blickrichtungs-Erkenners verwendet. Ein entscheidender Vorteil dieses Vorgehens ist, dass er ganz ohne Mitwirkung des Benutzers erfolgt und die Methode somit auch immer besser werden kann, je länger die Kamera neben dem Zielobjekt verbleibt und Daten aufnimmt. „Auf diese Weise verwandelt unsere Methode normale Kameras in einen Blickkontakt-Erkenner, ohne zuvor Größe oder Position des Zielobjektes kennen oder vorgeben zu müssen“, erklärt Bulling.

Die Forscher haben ihre Methode bisher in zwei Szenarien getestet: Am Arbeitsplatz, die Kamera war hier auf dem Zielobjekt montiert, und im Alltag, der Anwender trug hier eine Kamera am Körper, so dass sich eine ich-bezogene Perspektive ergab. Das Ergebnis: Da die Methode sich ihr nötiges Wissen selbst erarbeitet, ist sie robust, selbst wenn die Anzahl der Personen, die Lichtverhältnisse, die Kamerapositionen und die Zielobjekte in ihrer Art und Größe variieren.

Bulling schränkt ein: „Wir können zwar grundsätzlich Blickrichtungs-Cluster auf mehreren Zielobjekten mit nur einer Kamera identifizieren, aber die Zuordnung dieser Cluster zu den verschiedenen Objekten ist noch nicht möglich. Unsere Methode nimmt daher momentan an, dass der nächstgelegene Cluster zum Zielobjekt gehört und ignoriert die restlichen Cluster. Diese Einschränkung werden wir als nächstes angehen.“ Dennoch ist er überzeugt: „Die vorgestellte Methode ist ein großer Schritt nach vorne. Sie ebnet nicht nur den Weg für neue Benutzerschnittstellen, die Blickkontakt automatisch erkennen und auf diesen reagieren, sondern auch für Blickkontaktmessungen in alltäglichen Situationen, wie beispielsweise Außenwerbung, die bisher unmöglich waren.“

Weitere Informationen:

[1] Xucong Zhang, Yusuke Sugano and Andreas Bulling. Everyday Eye Contact Detection Using Unsupervised Gaze Target Discovery. Proc. ACM UIST 2017.

https://perceptual.mpi-inf.mpg.de/files/2017/05/zhang17_uist.pdf

[2] Xucong Zhang, Yusuke Sugano, Mario Fritz and Andreas Bulling. Appearance-Based Gaze Estimation in the Wild. Proc. IEEE CVPR 2015, 4511-4520.

https://perceptual.mpi-inf.mpg.de/files/2015/04/zhang_CVPR15.pdf

[3] Xucong Zhang, Yusuke Sugano, Mario Fritz and Andreas Bulling. It’s Written All Over Your Face: Full-Face Appearance-Based Gaze Estimation. Proc. IEEE CVPRW 2017.

https://perceptual.mpi-inf.mpg.de/files/2017/05/zhang_cvprw2017.pdf

Demo-Video:

https://www.youtube.com/watch?v=ccrS5XuhQpk

Fragen beantwortet:

Dr. Andreas Bulling

Perceptual User Interfaces Group

Exzellenzcluster „Multimodal Computing and Interaction“

Saarland Informatics Campus

Tel. +49 681 932 52128

E-Mail: bulling@mpi-inf.mpg.de

Redaktion:

Gordon Bolduan

Kompetenzzentrum Informatik Saarland

Saarland Informatics Campus

Telefon: +49 681 302-70741

E-Mail: bolduan@mmci.uni-saarland.de

Hinweis für Hörfunk-Journalisten:

Sie können Telefoninterviews in Studioqualität mit Wissenschaftlern der Universität des Saarlandes führen, über Rundfunk-Codec (IP-Verbindung mit Direktanwahl oder über ARD-Sternpunkt 106813020001). Interviewwünsche bitte an die Pressestelle (0681/302-3610).

Media Contact

Weitere Informationen:

http://www.uni-saarland.deAlle Nachrichten aus der Kategorie: Informationstechnologie

Neuerungen und Entwicklungen auf den Gebieten der Informations- und Datenverarbeitung sowie der dafür benötigten Hardware finden Sie hier zusammengefasst.

Unter anderem erhalten Sie Informationen aus den Teilbereichen: IT-Dienstleistungen, IT-Architektur, IT-Management und Telekommunikation.

Neueste Beiträge

Diamantstaub leuchtet hell in Magnetresonanztomographie

Mögliche Alternative zum weit verbreiteten Kontrastmittel Gadolinium. Eine unerwartete Entdeckung machte eine Wissenschaftlerin des Max-Planck-Instituts für Intelligente Systeme in Stuttgart: Nanometerkleine Diamantpartikel, die eigentlich für einen ganz anderen Zweck bestimmt…

Neue Spule für 7-Tesla MRT | Kopf und Hals gleichzeitig darstellen

Die Magnetresonanztomographie (MRT) ermöglicht detaillierte Einblicke in den Körper. Vor allem die Ultrahochfeld-Bildgebung mit Magnetfeldstärken von 7 Tesla und höher macht feinste anatomische Strukturen und funktionelle Prozesse sichtbar. Doch alleine…

Hybrid-Energiespeichersystem für moderne Energienetze

Projekt HyFlow: Leistungsfähiges, nachhaltiges und kostengünstiges Hybrid-Energiespeichersystem für moderne Energienetze. In drei Jahren Forschungsarbeit hat das Konsortium des EU-Projekts HyFlow ein extrem leistungsfähiges, nachhaltiges und kostengünstiges Hybrid-Energiespeichersystem entwickelt, das einen…