Von Fliegen Sehen lernen

Scheinbar plumpe und ordinäre Schmeißfliegen sind wahre Flugkünstler.

Plötzliche Richtungsänderungen, in der Luft stehen, blitzschnell um die eigene Achse drehen und punktgenaue Landungen sind für sie selbstverständlich. Extrem schnelle Augen helfen ihnen, im rasanten Hin und Her die Orientierung nicht zu verlieren.

Doch: Wie verarbeitet ihr winziges Gehirn so schnell und effizient die Vielzahl der Bilder und Signale? Um das zu ergründen, haben Wissenschaftler des Münchner Exzellenzclusters „Cognition for Technical Systems (CoTeSys)“ einen Flugsimulator für Fliegen gebaut. Hier erforschen sie, was in den Fliegengehirnen abläuft. Ihr Ziel: Dass Menschen diese Fähigkeiten nutzen können, etwa für Roboter, die eigenständig ihre Umgebung wahrnehmen und daraus lernen.

Fliegengehirne leisten Unglaubliches. Sie navigieren im schnellen Flug mit halsbrecherischen Kurven um Hindernisse, reagieren in Sekundenbruchteilen auf die Hand, die sie fangen will, und finden zielsicher zu den stark riechenden „Leckerbissen“, von denen sie leben. Seit langem weiß die Forschung, dass Fliegen sehr viel mehr Bilder wahrnehmen als Menschen. Während für menschliche Augen spätestens ab 25 Bildern pro Sekunde Einzelbilder in einen kontinuierlichen Bewegungsablauf übergehen, erkennen Schmeißfliegen noch 100 Bilder pro Sekunde als einzelne Sinneseindrücke, können sie blitzschnell interpretieren und so ihre Bewegung steuern und die Lage im Raum exakt bestimmen.

Dabei ist das Fliegengehirn kaum größer als ein Stecknadelkopf. Würde es genauso funktionieren, wie das Gehirn des Menschen, würde dies bei Weitem nicht zu solchen Leistungen ausreichen. Es muss die Bilder von den Augen also einfacher und sehr viel effizienter zu einer visuellen Wahrnehmung verarbeiten. Effiziente Wahrnehmung von visuellen Signalen aber ist etwas, was Roboterkonstrukteure ganz besonders interessiert, denn Roboter haben heute noch große Schwierigkeiten, ihre Umgebung nicht nur mit Kameras zu sehen, sondern auch wahrzunehmen, was sie sehen. Selbst das Erkennen von Hindernissen in ihrer eigenen Arbeitsfläche dauert viel zu lange. Daher müssen bislang beispielsweise Menschen noch mit Schutzgittern vor den maschinellen Helfern geschützt werden. Eine direkte, unterstützende Zusammenarbeit von intelligenten Maschinen und Menschen aber ist ein zentrales Forschungsziel des Exzellenzclusters „CoTeSys“ (Cognition for Technical Systems), zu dem sich im Raum München rund 100 Wissenschaftler von fünf Hochschulen und Forschungsinstituten zusammengefunden haben.

Im Rahmen von „CoTeSys“ erkunden Hirnforscher des Max-Planck-Instituts für Neurobiologie, wie Fliegen es schaffen, ihre Umwelt und ihre Bewegung so effizient wahrzunehmen. Unter Leitung des Neurobiologen Prof. Alexander Borst haben sie einen Flugsimulator für Fliegen gebaut. Hier werden Schmeißfliegen auf einem halbrunden Display unterschiedliche Muster, Bewegungen und Sinnesreize vorgespielt. Die Insekten sind an einem Halter befestigt, damit Elektroden die Reaktionen der Gehirnzellen registrieren können. Die Forscher analysieren so, was im Fliegengehirn passiert, wenn die Tiere wie wild kreuz und quer durch ein Zimmer sausen.

Die ersten Ergebnisse zeigen Eines ganz deutlich: Fliegen verarbeiten die Bilder ihrer unbeweglichen Augen ganz anders als das menschliche Gehirn. Bewegungen im Raum erzeugen sogenannte „optische Flussfelder“, die für eine ganz bestimmte Bewegung charakteristisch sind: Bei einer Vorwärtsbewegung fließen die Objekte seitlich vorbei, bei frontalem Anflug vergrößern sich die Objekte, nahe und weit entfernte Dinge bewegen sich ganz unterschiedlich. Die Fliege erstellt als ersten Schritt in ihrem winzigen Gehirn aus diesen Bewegungen ein Muster. Geschwindigkeit und Richtung, mit denen sich einzelne Bildpunkte vor den Augen scheinbar bewegen, ergeben in jedem Moment ein typisches Bild von Bewegungsvektoren, das Flussfeld, das schließlich in einem zweiten Schritt in der sogenannten „Lobula-Platte“ ausgewertet wird, einer höheren Ebene des Sehzentrums. In jeder Gehirnhälfte sind lediglich 60 Nervenzellen dafür zuständig – jede reagiert besonders intensiv, wenn das für sie passende Muster vorliegt. Wichtig für die Analyse der optischen Flussfelder ist, dass die Bewegungsinformation von beiden Augen zusammen geführt wird. Dies geschieht über eine direkte Verschaltung der spezialisierten Nervenzellen, sogenannte VS-Zellen. So ergibt sich für die Fliege eine exakte Information über ihre Lage und Bewegung.

„Durch unsere Ergebnisse ist das für Rotationsbewegungen zuständige Netzwerk der VS-Zellen im Fliegengehirn heute einer der am besten verstandenen Schaltkreise des Nervensystems“, erläutert Prof. Borst die Bedeutung dieser Untersuchungen. Diese Arbeiten bleiben aber nicht bei der reinen Grundlagenforschung stehen. Die Befunde der Martinsrieder Fliegenforscher sind besonders auch für die Ingenieure am Lehrstuhl für Steuerungs- und Regelungstechnik der Technischen Universität München (TUM) interessant, mit denen Prof. Borst im Rahmen von „CoTeSys“ eng zusammenarbeitet.

Die Forscher an der Technischen Universität entwickeln unter Leitung von Prof. Martin Buss und Dr. Kolja Kühnlenz intelligente Maschinen, die über Kameras ihre Umwelt beobachten, daraus lernen und flexibel auf die jeweilige Situation reagieren. Zielsetzung dieser Forschungsarbeiten sind intelligente Maschinen, die direkt mit dem Menschen umgehen können, auf ihn reagieren und ihn nicht gefährden. Auch die Schutzzäune in den Fabriken zwischen Menschen und Robotern sollen fallen. Dafür sind einfache, schnelle und effiziente Verfahren für die Analyse und die Interpretation von Kamerabildern unbedingt erforderlich.

Die TUM-Forscher entwickelten beispielsweise einen kleinen Flugroboter, der Fluglage und Bewegung durch visuelle Analyse im Computer nach dem Vorbild der Fliegengehirne kontrolliert. Einem fahrbaren Roboter, dem Autonomous City Explorer (ACE) wurde die Aufgabe gestellt, durch Ansprechen und Fragen von Passanten vom Institut zum etwa 1,5 Kilometer entfernten Münchner Marienplatz zu finden. Dabei musste er auch die Gesten der Menschen interpretieren, die ihm den Weg zeigten, und er musste sich –verkehrsgerecht – ausschließlich auf dem Gehsteig bewegen.

Ohne effiziente Bildanalyse ist ein Zusammenspiel von intelligenten Maschinen und Menschen nicht denkbar. Die Forschungsarbeiten am Flugsimulator für Fliegen bieten dafür durch den Austausch der Wissenschaftler aus unterschiedlichen Disziplinen im Rahmen von CoTeSys einen interessanten Ansatz, der auch einfach genug erscheint, um technisch umsetzbar zu sein.

Kostenfreies Bildmaterial

zum Thema erhalten Sie unter

http://www.cotesys.de/media/pictures-for-press.html

Weitere Informationen:

CoTeSys: www.cotesys.org

Max-Planck-Institut für Neurobiologie: www.neuro.mpg.de

Für Rückfragen:

Dr. Uwe Haass,

Geschäftsführer CoTeSys

CCRL – CoTeSys Central Robotics Laboratory

Technische Universität München

Barer Straße 21, 80290 München

Telefon 089- 289 25 723

E-Mail: gst@tum.de

Media Contact

Alle Nachrichten aus der Kategorie: Interdisziplinäre Forschung

Aktuelle Meldungen und Entwicklungen aus fächer- und disziplinenübergreifender Forschung.

Der innovations-report bietet Ihnen hierzu interessante Berichte und Artikel, unter anderem zu den Teilbereichen: Mikrosystemforschung, Emotionsforschung, Zukunftsforschung und Stratosphärenforschung.

Neueste Beiträge

Merkmale des Untergrunds unter dem Thwaites-Gletscher enthüllt

Ein Forschungsteam hat felsige Berge und glattes Terrain unter dem Thwaites-Gletscher in der Westantarktis entdeckt – dem breiteste Gletscher der Erde, der halb so groß wie Deutschland und über 1000…

Wasserabweisende Fasern ohne PFAS

Endlich umweltfreundlich… Regenjacken, Badehosen oder Polsterstoffe: Textilien mit wasserabweisenden Eigenschaften benötigen eine chemische Imprägnierung. Fluor-haltige PFAS-Chemikalien sind zwar wirkungsvoll, schaden aber der Gesundheit und reichern sich in der Umwelt an….

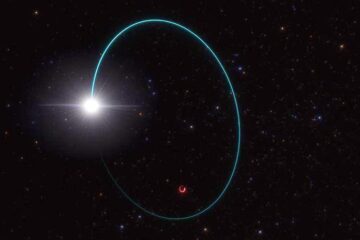

Das massereichste stellare schwarze Loch unserer Galaxie entdeckt

Astronominnen und Astronomen haben das massereichste stellare schwarze Loch identifiziert, das bisher in der Milchstraßengalaxie entdeckt wurde. Entdeckt wurde das schwarze Loch in den Daten der Gaia-Mission der Europäischen Weltraumorganisation,…