Die selbstlernende Roboterhand

Obwohl die Roboterhände die Kraft hätten, den Apfel fest zu drücken, dosieren sie ihre Kraft für einen feinfühligen Griff, der auch empfindlichen Objekten nicht schadet. Foto: Universität Bielefeld

Forschende der Universität Bielefeld haben ein Greifsystem mit Roboterhänden entwickelt, das sich selbständig mit unbekannten Gegenständen vertraut macht. Das neue System funktioniert, ohne vorher die Merkmale von Objekten wie Obst oder Werkzeug zu kennen. Entwickelt wurde das Greif-Lern-System im Großprojekt „Famula“ des Exzellenzclusters Kognitive Interaktionstechnologie (CITEC) der Universität Bielefeld.

Das Wissen aus dem Projekt könnte zum Beispiel dazu beitragen, dass künftige Serviceroboter sich selbst in neue Haushalte einarbeiten. CITEC investiert für Famula rund eine Million Euro. In einem neuem „research_tv“-Beitrag der Universität Bielefeld erklären die Leiter des Projekts die Neuentwicklung.

„Unser System lernt durch Probieren und eigenes Erkunden – so wie auch Babys sich neuen Objekten widmen“, sagt Professor Dr. Helge Ritter. Der Neuroinformatiker leitet das Projekt zusammen mit dem Sportwissenschaftler und Kognitionspsychologen Professor Dr. Thomas Schack und dem Robotiker Privatdozent Dr. Sven Wachsmuth.

Die CITEC-Wissenschaftler arbeiten mit einem Roboter mit zwei Händen, die menschlichen Händen in Form und Beweglichkeit nachempfunden sind. Das Robotergehirn für diese Hände muss lernen, wie alltägliche Objekte, etwa Obst, Geschirr oder auch Plüschtiere, durch ihre Farben und Formen unterschieden werden können, und worauf es ankommt, wenn man sie greifen will.

Der Mensch als Vorbild

Eine Banane lässt sich umgreifen, ein Knopf sich drücken. „Das System lernt, solche Möglichkeiten aus Merkmalen zu erkennen und baut sich ein Modell für den Umgang und die Wiedererkennung auf“, sagt Ritter.

Dafür verbindet das interdisziplinäre Projekt Arbeiten in der künstlichen Intelligenz mit Forschungsarbeiten in weiteren Disziplinen. So untersuchte die Forschungsgruppe von Thomas Schack, welche Merkmale Versuchspersonen als bedeutsam bei Greifaktionen wahrnehmen. In einer Studie mussten die Probanden die Ähnlichkeit von mehr als 100 Objekten vergleichen.

„Überraschend war, dass das Gewicht kaum eine Rolle spielt. Wir Menschen verlassen uns vor allem auf die Form und die Größe, wenn wir Dinge unterscheiden“, sagt Thomas Schack. In einer weiteren Studie ließen sich Testpersonen die Augen verbinden und hantierten mit Würfeln, die sich in Gewicht, Form und Größe unterschieden. Infrarotkameras zeichneten die Handbewegungen auf.

„Dadurch erfahren wir, wie Menschen einen Gegenstand ertasten und welche Strategien sie bevorzugt nutzen, um seine Eigenschaften zu erfassen“, sagt Dirk Koester, Mitarbeiter in Schacks Forschungsgruppe. „Wir erfahren natürlich auch, welche Fehler Menschen beim blinden Ertasten machen.“

System versetzt sich in die Position seines „Mentors“

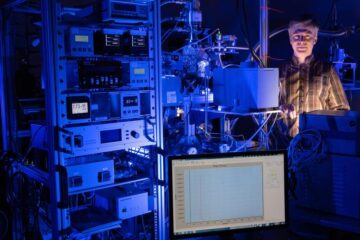

Vor einem großen Metallkäfig mit den beiden Roboterarmen und einem Tisch mit verschiedenen Testobjekten steht Dr. Robert Haschke, Mitarbeiter von Helge Ritter. Er hilft dem System in der Rolle eines menschlichen Lern-Mentors beim Erlernen neuer Gegenstände. So sagt er den Händen, welches Objekt auf dem Tisch sie als nächstes inspizieren sollen. Dazu zeigt Haschke auf einzelne Objekte oder gibt sprachliche Hinweise, wie etwa eine Richtung („hinten links“), in der für den Roboter ein interessantes Objekt zu finden ist. Zwei Monitore zeigen, wie das System über Farbkameras und Tiefensensoren seine Umgebung wahrnimmt und auf die Kommandos des Menschen reagiert.

„Die Hände müssen mündliche Sprache, aber auch Gestik deuten können, um zu verstehen, mit welchem Objekt sie sich befassen sollen“, erklärt Sven Wachsmuth vom CITEC-Zentrallabor. „Und sie müssen sich in die Position des Menschen versetzen können, auch um nachzufragen, ob sie richtig verstanden haben.“ Wachsmuth und sein Team sind nicht nur für die Sprachkompetenz des Systems zuständig. Sie haben ihm auch ein Gesicht gegeben: Von einem der Bildschirme aus verfolgt Flobi die Bewegung der Hände und reagiert auf die Anweisungen der Wissenschaftler. Flobi ist ein stilisierter Roboterkopf, der die Sprache und die Handlungen des Roboters durch Gesichtsausdrücke ergänzt. Als Teil des Famula-Systems ist derzeit die virtuelle Version des Roboters im Einsatz.

Die menschliche Interaktion verstehen

Mit Famula betreiben die CITEC-Forscher Grundlagenforschung, die künftigen selbstlernenden Robotern in Haushalt und Industrie zugutekommen kann. „Wir wollen verstehen, wie wir lernen, unsere Umwelt dank unserer Hände buchstäblich zu begreifen. Der Roboter ermöglicht uns dabei, unsere Erkenntnisse in der Realität zu überprüfen und Lücken in unserem Verständnis schonungslos aufzudecken. Dadurch leisten wir einen Beitrag für den künftigen Einsatz komplexer, vielfingriger Roboterhände, die heute noch zu kostspielig und zu komplex für den Einsatz zum Beispiel in der Industrie sind“, sagt Ritter.

Der Projektname Famula steht für „Deep Familarization and Learning Grounded in Cooperative Manual Action and Language: from Analysis to Implementation” – zu Deutsch etwa: Intensives Vertrautmachen und Lernen bei kooperativen Handbewegungen und Sprache: von der Untersuchung zur Umsetzung“. Das Projekt läuft seit 2014 und ist zunächst bis Oktober 2017 befristet.

Acht Forschungsgruppen des Exzellenzclusters CITEC arbeiten an Famula mit. Es ist eins von vier CITEC-Großprojekten. Die weiteren Projekte sind das Roboter-Service-Apartment, der Laufroboter Hector und die virtuelle Trainingsumgebung ICSpace. CITEC wird als Teil der Exzellenzinitiative von der Deutschen Forschungsgemeinschaft (DFG) im Auftrag von Bund und Ländern gefördert (EXC 277).

Weitere Informationen im Internet:

• Beitrag zu Famula bei research_tv: https://youtu.be/dIvFjkkrG20

• „Vom Begreifen“ (Artikel im Forschungsmagazin BI.research, S. 22): http://bit.ly/2qmG6RI

• Übersicht der Forschungsprojekte am CITEC: https://cit-ec.de/de/projekte

Kontakt:

Prof. Dr. Helge Ritter, Universität Bielefeld

Exzellenzcluster Kognitive Interaktionstechnologie (CITEC)

Telefon: 0521 106-12123

E-Mail: helge@techfak.uni-bielefeld.de

Media Contact

Weitere Informationen:

http://www.uni-bielefeld.de/Alle Nachrichten aus der Kategorie: Informationstechnologie

Neuerungen und Entwicklungen auf den Gebieten der Informations- und Datenverarbeitung sowie der dafür benötigten Hardware finden Sie hier zusammengefasst.

Unter anderem erhalten Sie Informationen aus den Teilbereichen: IT-Dienstleistungen, IT-Architektur, IT-Management und Telekommunikation.

Neueste Beiträge

Ideen für die Zukunft

TU Berlin präsentiert sich vom 22. bis 26. April 2024 mit neun Projekten auf der Hannover Messe 2024. Die HANNOVER MESSE gilt als die Weltleitmesse der Industrie. Ihr diesjähriger Schwerpunkt…

Peptide auf interstellarem Eis

Dass einfache Peptide auf kosmischen Staubkörnern entstehen können, wurde vom Forschungsteam um Dr. Serge Krasnokutski vom Astrophysikalischen Labor des Max-Planck-Instituts für Astronomie an der Universität Jena bereits gezeigt. Bisher ging…

Wasserstoff-Produktion in der heimischen Garage

Forschungsteam der Frankfurt UAS entwickelt Prototyp für Privathaushalte: Förderzusage vom Land Hessen für 2. Projektphase. Wasserstoff als Energieträger der Zukunft ist nicht frei verfügbar, sondern muss aufwendig hergestellt werden. Das…